随着ChatGPT的广泛使用,越来越多的人开始关注大型语言模型训练。这些模型能够自动理解和生成自然语言,例如文本生成、机器翻译和问答系统等任务。然而,这些模型需要大量和高质量的数据和标注才能训练,而标注数据的质量对模型的性能至关重要。

在大型语言模型的训练中,数据标注是必不可少的步骤之一。通过标注数据,模型可以学习语言的语法、语义和结构,从而提高在自然语言处理任务中的表现。但是,对于研究人员来说,人工标注数据的收集和处理是一项非常费时费力的任务。因此,他们一直在探索如何减轻标注数据的工作量,比如利用半监督和迁移学习等方式,从而有效提高标注效率,并使模型的训练更加高效和精确。

为了标注数据,可以采用自动标注技术,如命名实体识别、词性标注和句法分析。这些技术可以降低手动标注的工作量,但标注质量取决于算法和数据质量,因此需要进行仔细的选择和评估。

另一种方法是使用迁移学习,即先使用大量标注数据训练模型,并将其应用于特定任务。这种方法可以减少对任务特定标注数据的依赖,使模型更容易训练和优化。

除了标注数据之外,计算资源也是训练大型语言模型的关键因素之一。通常需要使用大规模的并行计算集群,并使用一些优化技术,例如梯度下降和自适应学习率。平衡标注数据和计算资源的使用是实现高质量训练的关键。

总之,训练高质量的大型语言模型需要大量的数据和标注,以及大规模的计算资源。在数据标注方面,自动标注技术和迁移学习可以帮助减少标注数据的工作量。在计算资源方面,需要使用大规模的并行计算集群和优化技术,以实现高质量的训练。

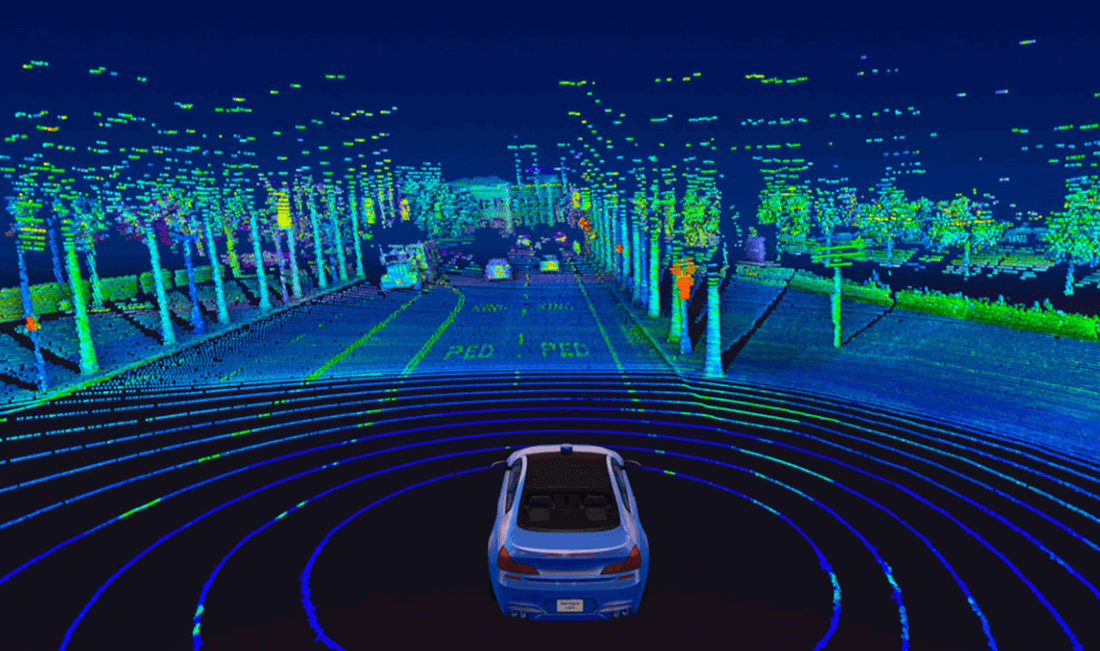

倍赛科技作为AI训练数据行业领导者,致力于打造全球化AI赋能的Data-Centric MLOps 软件基础设施。构建了从数据标注、AI数据管理到模型训练的AI全生命周期软件及服务体系。支持3D点云、视频、图像、语音、文本及混合模态的AI数据类型,集成强大的数据预标注、自定义数据流程管理、人机耦合及协同、一键式AI模型训练与容器化部署等功能,帮助客户快速完成数据与模型迭代,高质量、高效率实现AI场景落地。

上一篇

下一篇